Une fois un processus d'entraînement effectué à l'aide de l'outil Entraîner le modèle de classification du nuage de points, vous voulez en évaluer les résultats. L'objectif est de créer un modèle capable de classer avec précision le type de données qu'il a été conçu pour classer. Il ne doit pas seulement être efficace sur les données utilisées pour l'entraînement, mais aussi sur d'autres données qui n'en ont pas fait l'objet.

L’outil Entraîner le modèle de classification du nuage de points fournit en sortie différents éléments qui vont vous aider à effectuer cette évaluation.

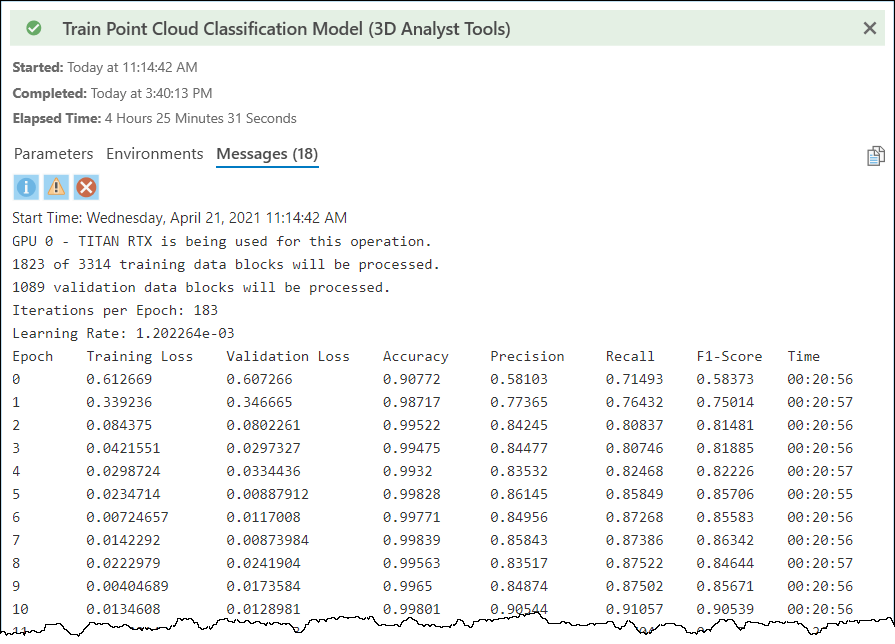

En outre, pendant qu'il s'exécute, l'outil renvoie des informations de synthèse par époque. Le temps pris par époque constitue aussi un élément en sortie qui vous aidera à déterminer le temps que prendra le traitement si toutes les époques sont exécutées. Vous pouvez voir les métriques prises en compte dans les messages de l'outil. La moyenne de la précision, du rappel et des scores F-1 est calculée pour toutes les classes avec une pondération pour chacune, la macro-moyenne.

Pour interpréter ces métriques, vous devez en comprendre le sens. Vous trouverez ci-après une petite introduction, mais nous vous recommandons d'approfondir de votre côté vos connaissances sur ces statistiques, leur utilisation et leur interprétation à l'aide des ressources disponibles dans cette rubrique.

Exactitude : pourcentage de points correctement prédits sur le total. Notez que cette métrique n'est pas utile si les points de classes volumineuses se révèlent peu nombreux par rapport aux autres classes. Cela en dû au fait que vous pouvez obtenir un pourcentage global de prédictions correctes élevé tout en ayant des prédictions erronées sur peu de points, mais importants.

Précision : fraction de prédictions correctes pour une classe par rapport à tous les points prédits de cette classe, de façon correcte ou erronée.

Rappel : fraction de prédictions correctes pour une classe par rapport à tous les points appartenant vraiment à cette classe.

Score F-1 : moyenne harmonique de la précision et du rappel.

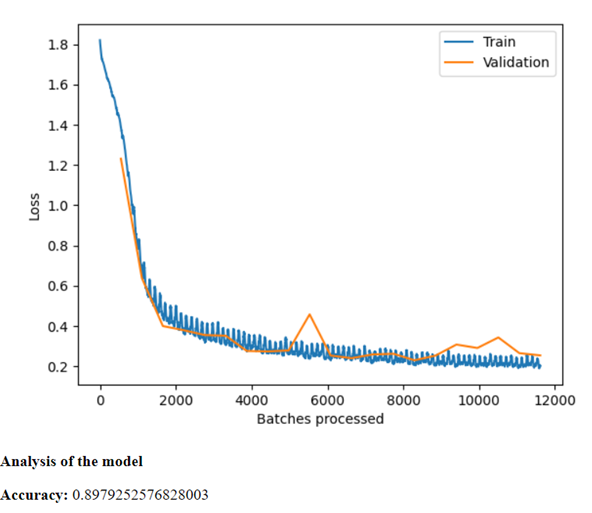

L'outil d'entraînement fournit également en sortie un graphique des courbes d'apprentissage. Il peut être consulté dans les messages de l’outil et est également enregistré dans le dossier des modèles en sortie, dans un fichier nommé model_metrics.html. Le graphique illustre les courbes de perte de validation et de perte d'entraînement. Les pertes faibles étant préférables, il vaut mieux que les courbes baissent dans le temps et se stabilisent. La perte d'entraînement montre comment le modèle a appris, tandis que la perte de validation met en évidence la généralisation de l'apprentissage.

Vous pouvez évaluer le sous-apprentissage et le surapprentissage du modèle en examinant les courbes de perte. On parle de sous-apprentissage du modèle soit s'il est incapable d'apprendre le jeu de données d'entraînement, soit s'il a besoin de plus d'entraînement. Les modèles en sous-apprentissage se reconnaissent par une courbe de perte d'entraînement plate ou bruyante du début à la fin, ou qui baisse tout le long jusqu'à la fin, sans jamais se stabiliser. On parle de surapprentissage du modèle lorsqu'il a bien appris aussi les données d'entraînement mais ne généralise pas, c'est-à-dire qu'il ne fait pas de bonnes prédictions avec d'autres données. Les modèles en surapprentissage se reconnaissent par une courbe de perte de validation qui baisse jusqu'à un point puis remonte ou se stabilise, par rapport à la perte d'apprentissage. Un bon modèle s'illustre généralement par des pertes de validation et d'apprentissage qui diminuent jusqu'à un point de stabilité avec un écart minimal entre les deux valeurs de perte finales.

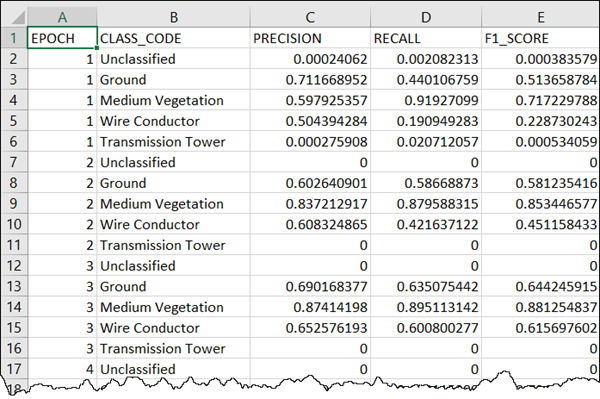

L’un d’entre eux est un fichier texte *.csv nommé model_name_Statistics.csv et placé dans le dossier des modèles en sortie. Pour chaque classe par époque il contient la précision, le rappel et les scores F-1.

Outre l'examen des métriques et des courbes d'apprentissage, vous pouvez utiliser le modèle résultant sur des données différentes à la fois de vos données d'entraînement et de validation. Consultez les résultats en examinant le nuage de points dans une scène 3D dans laquelle les points sont symbolisés par code de classe.

Rubriques connexes

Vous avez un commentaire à formuler concernant cette rubrique ?